TensorRT的部署真的够麻烦的,害怕以后换电脑忘记怎么弄了,先记下来

首先先安装好CUDA和Cudnn,时间已经隔得够长了我已经完全忘了怎么装了,我们先假设已经装好了,然后就是去NVIDIA官网下载TensorRT的压缩包

1 将TensorRT压缩包解压

2 将 TensorRT-X\include中头文件复制到C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\vX\include

3 将TensorRT-X\lib 中所有lib文件复制到C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\vX\lib\x64

4 将TensorRT-X\lib 中所有dll文件复制到C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\vX\bin

然后验证TensorRT是否安装成功

打开 TensorRT-X\samples\sampleMNIST\sample_mnist.sln

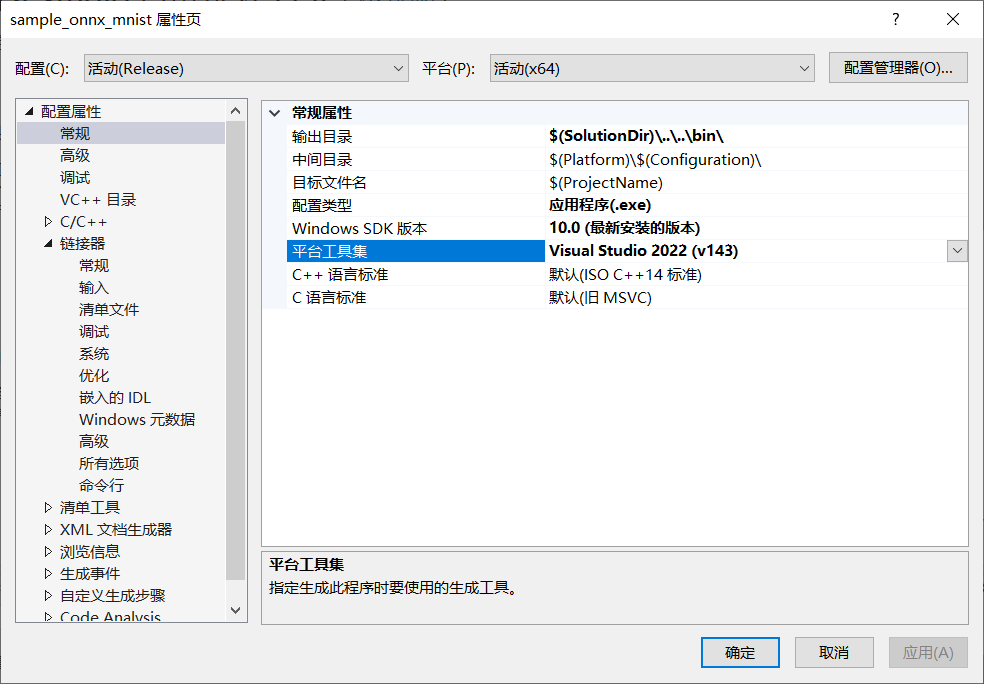

根据解决方案重定向,右键工程->属性,修改平台工具集

右键工程->重新生成

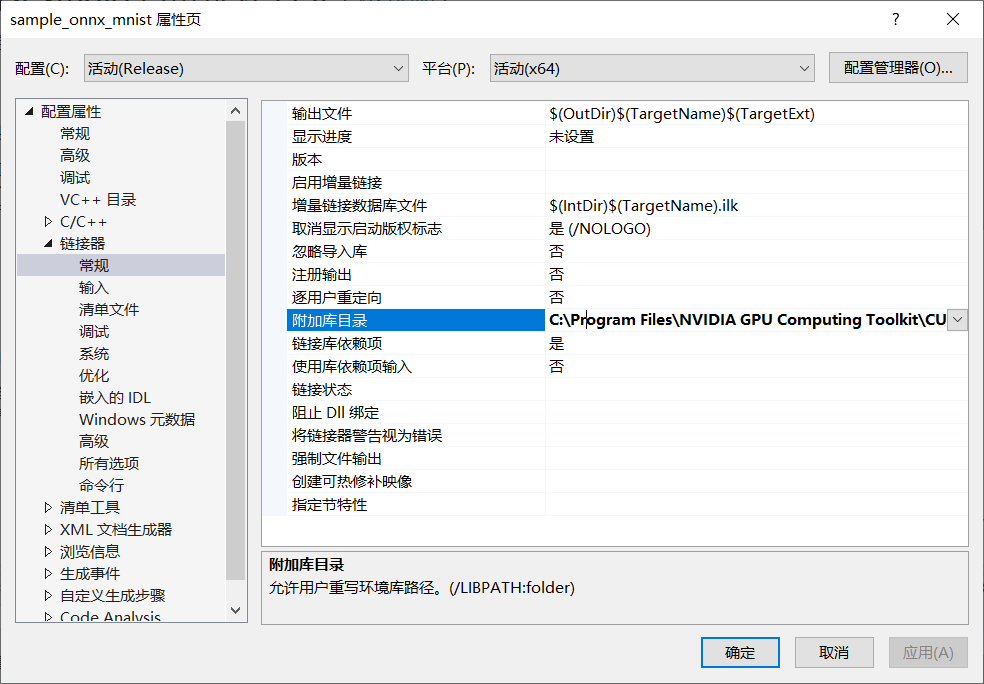

然后发现不行,会提示你无法打开输入文件cudnn.lib,这个文件在cuda文件夹里,得在链接器-附加库目录中添加路径C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.7\cudnn\lib\x64

进入Anaconda虚拟环境,进入TensorRT-7.0.0.11\data\mnist目录,运行python download_pgms.py,如果TensorRT版本够高,就已经下好了

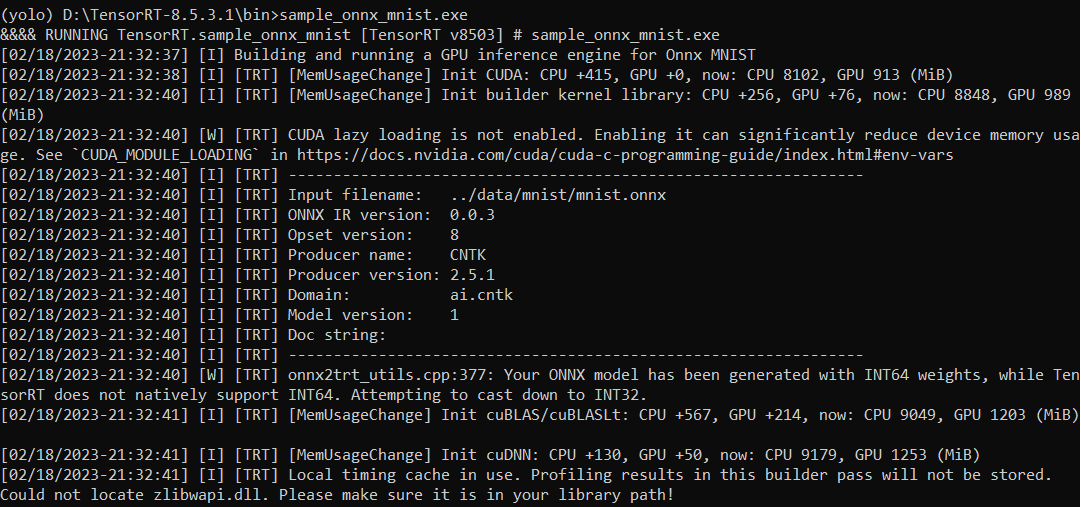

进入TensorRT-7.0.0.11\bin,双击sample_mnist.exe,如果没有报错则说配置成功。

但是一般都会报错:Could not locate zlibwapi.dll. Please make sure it is in your library path!

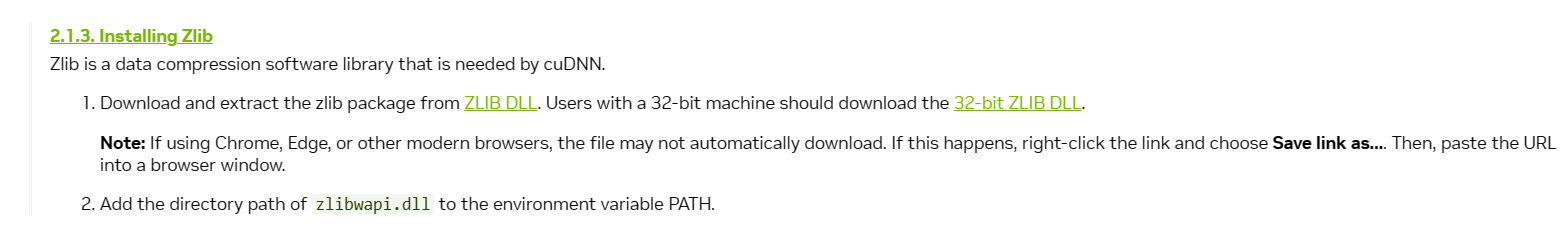

Installation Guide :: NVIDIA Deep Learning cuDNN Documentation

http://www.winimage.com/zLibDll/zlib123dllx64.zip

到这条链接下载zlib压缩包,edge可能还下载不了,得去谷歌浏览器

解压以后将zlibwapi.dll移动到C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\vX\bin

再次运行就可以了